메타버스를 향한 Facebook의 AI 연구 프로젝트 Ego4D

2021-11-08

지난 10월 말, 페이스북은 사명을 메타로 변경한다고 발표했다. 페이스북 우선이 아닌 메타버스 우선으로 사업을 펼쳐 나갈 것이라는 것을 시사하는 것으로 보이며, 이미 시작한 메타버스를 향한 그들의 AI 연구 프로젝트 Ego4D를 소개한다.

페이스북은 증강현실(AR)과 가상현실(VR) 세계를 창출하는 데 있어 인공지능(AI)이 「자기중심적 관점」을 획득해야 한다고 생각하고 있다.

그 목표를 추진하기 위해 페이스 북은 미국 시간 10월 14일, 「Ego4D」를 발표했다. 이것은 약 3000시간에 이르는 1인칭 시점의 동영상 데이터 세트와 뉴럴 네트워크(NN)의 벤치마크 테스트 세트로 구성되어 있다.

목적은, AI가 가상 세계에서 능숙하게 처리하는데 필요한 지식 개발을 1인칭의 시점에서 시도하려는 것이다.

제공: 페이스북 AI

이 프로젝트는, 페이스북 Reality Labs과 학술 기관 그리고 연구소 등 13개 연구기관에 소속해 있는 학자들이 함께하는 공동 연구다. 그 자세한 내용은, 페이스북의 Kristen Grauman씨가 필두 저자가 되어 쓴 「Ego4D: Around the World in 3,000 Hours of Egocentric Video」 (Ego4D: 자기 중심적 동영상 3000시간 세계 일주)에 기록되어 있다.

Grauman 씨는 페이스북의 AI 연구부문인 페이스북 AI Research(FAIR)의 과학자로, 텍사스 대학 오스틴교에서 컴퓨터 비전과 기계 학습(ML)에 관한 분야에서 연구를 진행해온 교수이다.

이 아이디어는, 「ImageNet」 같은 대규모 데이터 세트가 「관측자」 시점에서 기존 AI 프로그램 발전이 촉진되었던 것처럼, 이 데이터 세트에 의해 1인칭 시점 태스크 실행이 NN 발전을 재촉하는 힘을 연구에 가져온다.

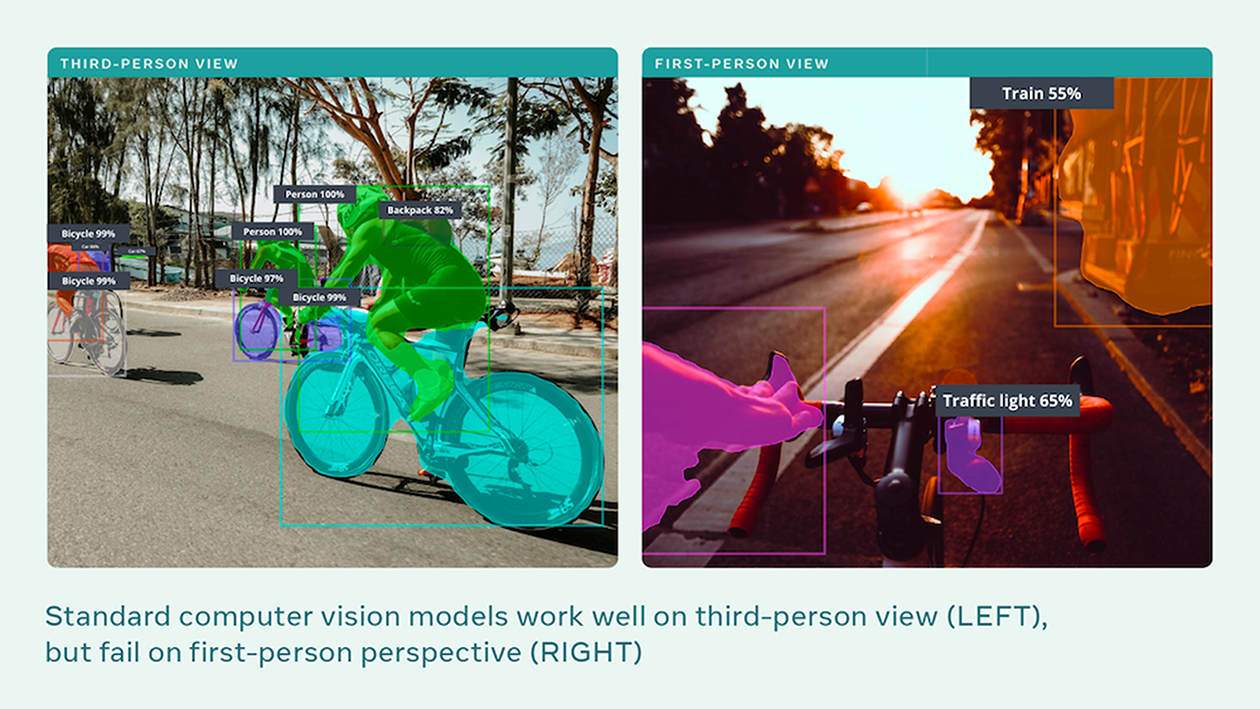

Facebook에 의하면, 자기중심적 시점의 포인트는, 예를 들면 화상 인식과 관련 있는 기본 태스크에 있어서, 3인칭의 시점에서 1인칭의 시점으로 옮겨졌을 경우에 발생하는 NN의 문제를 해결하려는 것이라고 한다.

대부분의 화상인식 시스템은 측면에서 보는 물체를 검출할 수는 있지만 그 물체를 사람이 직접 취급할 때처럼 정면으로 본 형태로 제시되면 인식하는 정도가 저하된다.

Ego4D라는 시도는, 메타버스, 즉 몰입형 소셜 네트워킹이라고 하는 차세대로 목표를 조준한 것이다. 페이스북의 메타버스 전략은 CEO인 마크 져커버그가 2021년 2/4 분기 결산 발표 때도 말했다.

페이스북은 "Ego4D 벤치마크를 통해 현실 세계뿐만 아니라 메타버스, 즉 현실과 AR, VR 모두를 융합하는 단일공간을 이해하고 이것을 통해 소통이 가능하고 보다 스마트한 AI 어시스턴트를 개발하는데 필요한 빌딩블록 연구가 촉진될 것"이라고 밝혔다.

페이스북의 실무진들은, 다양한 카메라를 이용해 약 3000시간에 이르는 동영상을 촬영했다. Vuzix의 스마트글라스인 Vuzix Blade도 그 중 하나이며, 그 외에 GoPro, Pupil Labs, Zetronix, WEEVIEW의 카메라도 사용하였다. Grauman 씨와 공동연구자들에 의하면, 다양한 카메라를 사용한 이유는 NN이 서로 다른 대상의 유사점을 추론하는 것이 아니라 동영상 프레임 정보 자체를 기억해버리는 「과잉 적합」 현상을 피하기 위해서라고 한다.

페이스북은 세계 각지의 73개 지역, 9개국 750여 명이 장비를 잘 갖춘 카메라로 촬영했다고 밝혔다. 촬영진은 Facebook의 연구 실무진과 대학의 공동 연구자로 구성되었다.

Ego4D라는 명칭에 있는 「4D」란, Facebook의 실무진이 이 동영상을 시청하고 타임 스탬프 첨부로 그 동영상의 내용을 음성으로 해설하였는데, 25만 시간 분으로 그 시간적인 축을 의미한다.

이 동영상 음성해설의 분당 문장 수는 약 13.2개로 총 385만 문장이 있다. Ego4D 동영상에는 전체 1772종의 동작 동사와 4336종의 물질 명사가 사용되고 있어 시간 축과 밀접하게 관련되어 있다고 전한다.

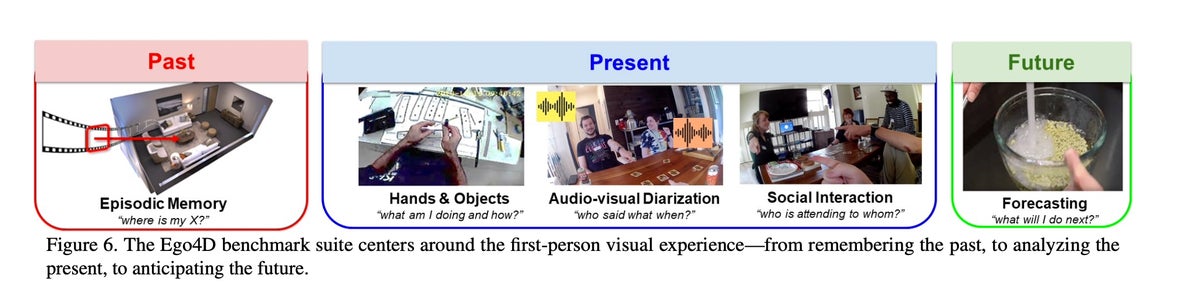

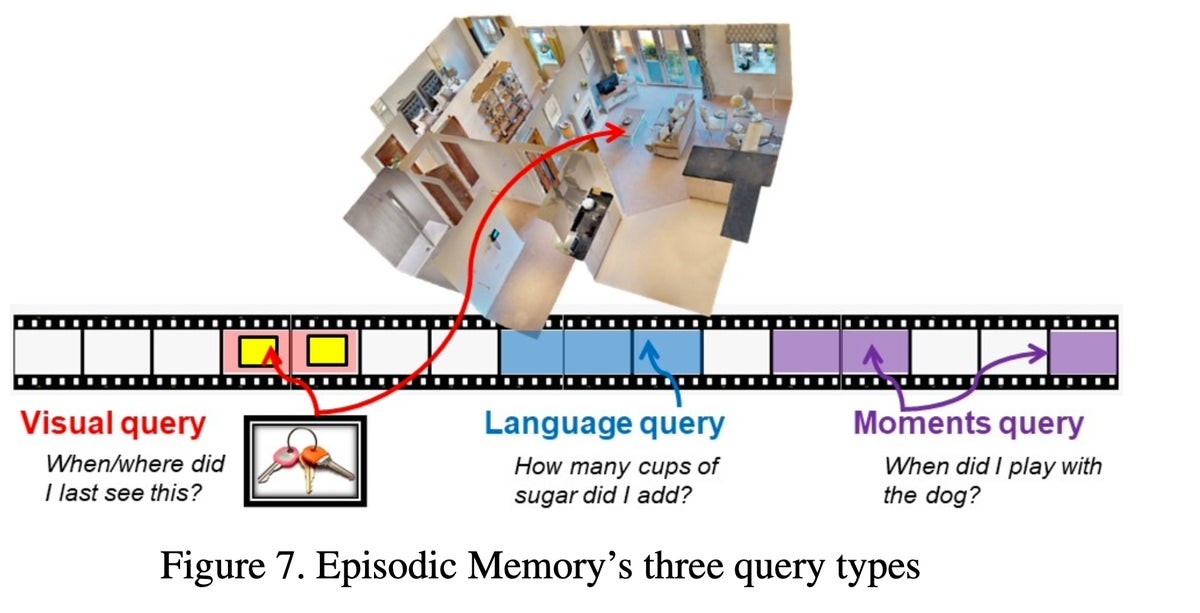

이 데이터 세트는 다양한 신규 벤치마크 테스트에서 실행되는 NN 개발에 사용될 것이다. Grauman 씨와 공동연구자들은 이러한 점에서 과거의 회상을 추적하는 태스크나 액티비티를 분류하는 것 같은 현재의 태스크, 행동결과의 묘사 같은 미래예측 태스크에 대응 가능한 응답을 생성할 수 있는 NN을 개발할 때 필요한 새로운 테스트를 여럿 작성하여 해설하고 있다.

제공: 페이스북 AI

NN의 태스크는, 자연 언어로 질문을 받아들여 그 컨텐츠에 적합한 동영상 프레임으로 응답하는 것 같은 생각이 든다.

예를 들면, “언제 아이들에게 읽어주었느냐”는 질문을 컴퓨터에 던졌을 경우, 컴퓨터는 카메라 장착자가 아이들에게 읽어주고 있는 장면을 검색해야 한다. 이러한 태스크를 실행하기 위해서는 미리 포맷이 정해진 라벨 일람과 동영상의 해당 부분을 관련 지어 가라는 지시를 받은 해설 실무진에 의해 작성된 라벨이 있는 데이터가 필요하다.

따라서, 페이스북이 준비한 800시간 분의 동영상에는 7만 4000개의 질문이 할당되었다고 한다.

제공: 페이스북 AI

미래 예측 테스트는 카메라 장착자가 동영상 프레임 안에 있는 어떤 물체와 다음에 주고받을 질문을 컴퓨터가 예측해야 한다.

카메라 장착자가 조리대 위에서 밀가루를 반죽을 만들고 있을 경우 다음에 예측되는 행동은 조리대 위의 그 반죽을 잡는 것이 될 것이다. 이 프로그램은, 해설 실무진에 의해서 동영상 프레임에 할당된 동사 리스트 중에서 어느 것을 선택하고, 시간 예상치를 부가해 「0.8초 이내에 옷감을 잡는다」라고 하는 출력을 제시하는 방식으로 예측 하게 된다.

페이스북에 의하면, Ego4D의 데이터 세트는 GitHub에 11월 공개될 예정이다. 유저는 데이터 사용에 관한 합의서에 서명해야만 사용할 수 있게 된다.

출처 : zdnet