*Enterprise-IoT

*Smart Machine 사례연구

*Middleware 사례연구

*AI·Big Data 사례연구

*IoT 사례연구

*Smart Thinks 사례연구

*정부정책동향 사례연구

*K-SmartFactory

*Hidden Champion

*카드뉴스

*국내외 동향 리포트

e. 사례 연구 : CERN (유럽 원자핵 공동 연구소)의 LHCb 실험

유럽 원자핵 공동 연구소 CERN은 고에너지 물리학 연구에 필요한 입자 가속기를 가동하고 있다. 현재 CERN은 가속기 6개의 네트워크를 운영하고 있다. 각각의 가속기는 다양한 실험 또는 다음으로 더 강력한 가속기에 연쇄적으로 입자 빔을 전달하기 전에 입자 빔의 에너지를 증가시킨다. 대형 강입자 충돌 가속기 (LHC)는 6개의 가속기 중에서 가장 큰 것이다. 지하 100 미터에 위치한 LHC는 빔 입자의 에너지를 높이기위해 구조를 가속할뿐 아니라, 입자 빔을 제어하는 27km 링 모양의 초전도 자석으로 구성되어 있다. LHC 안에서는 반대 방향에서 거의 빛의 속도로 이동하는 두 개의 입자 빔이 충돌하게 된다. 이는 10km 떨어져있는 두 개의 바늘이 발사되어 중간에서 충돌할 정도의 정밀도에 필적한다. 이러한 종류의 실험의 시행을 필요로 하는 이 기계는 수만 톤의 무게가 나가며, 우주에서의 삶이 처음 시작되었을 때 만연했던 것과 유사한, 예를 들어 높은 수준의 방사능과 극한의 온도와 같은 척박한 조건을 수용할 수 있어야 한다.

LHC에서 현재 진행되고 있는 주요 실험이 4개 있다. LHCb 실험 중 하나는 본 사례 연구의 주안점이다. 그것은 LHC 빔의 충돌 지점 중 하나의 주변에 있는 거대한 지하 동굴에 설치된다. LHCb의 목적은 반물질의 증거를 찾는 것이며, 이는 “뷰티 쿼크” (LHCb의 “b”)라고 불리는 입자를 찾음으로써 이루어진다.

다른 실험과 마찬가지로, LHCb는 빛의 속도로 움직이는 특정 입자가 충돌할 때 무슨 일이 일어나는지 조사하도록 설계되었다. 충돌 지점에서 많은 입자가 생성된다. 이 입자 중 일부는 매우 불안정하며, 더 가벼운 입자로 부패하기 전 1초도 안되는 순간 동안만 존재한다. 이 모든 것을 뒷받침하는 물리학 이론에 대한 자세한 내용은 [CERN09]를 참조해라.

LHCb와 데이터 관리

LHC는 초당 6억개 입자 충돌까지 (4천만 빔 횡단 중에 = 40 MHz) 발생한다. 각 충돌의 디지털화 요약은 “충돌 사건”으로 기록된다. 글을 쓰는 시점에서, CERN은 매년 약 30 페타바이트의 데이터를 저장한다. 이 데이터는 충돌이 이론을 증명하는 증거를 만들어내는지 알아내기 위해 물리학에 의해 분석될 필요가 있다.

LHCb 실험의 1,000,000개 이상의 센서는 거대한 양의 데이터를 생성합니다. 방대한 센서 부대에 의해 생산된 모든 아날로그 데이터를 저장하고 분석하는 것이 가능해지기 전까지 아직 어느 정도의 시간이 있다. 최근 CERN 오픈랩의 CTO에서 은퇴한 Sverre Jarp에 따르면, “LHC 의해 만들어진 방대한 양의 아날로그 데이터를 모두 관리하고 유지하는 것이 불가능하기 때문에, 우리는 추가적인 분석을 위한 데이터의 효율적인 디지털화, 압축, 필터링 및 분배를 위한 전략을 고안해야 했다. 이 문제에 대한 우리의 솔루션은 월드와이드 LHC 컴퓨팅 그리드 (WLCG)이다. WLCG는 LHC 데이터를 사전 처리하기 위해 사용되는 저가 컴퓨터의 대규모 그리드이다. 또한 우리는 8,000명 이상의 물리학자에게 거의 실시간으로 사후 처리 데이터에의 접근권을 제공하기 위해서 CERN에서 발명된 월드 와이드 웹을 사용한다.“고 한다.

CERN의 오픈랩에서 자신의 오랜 재임 기간 동안 Sverre Jarp와 긴밀하게 협력한 Andrzej Nowak이 설명 하듯이: “우리의 도전은 10조 중에서 하나의 사건을 찾는 것이다. 우리가 이10 조의 사건들에 의해 생성 된 아날로그 데이터 모두를 유지할 수 없기 때문에, 우리는 데이터의 일부를 필터링해야 한다. 물리학자들은 우리가 모든 것을 가치있게 만들 하나의 황금 곡식을 버릴 것 두려워하기 때문에, 이는 그들을 화나게 만든다. 그래서 우리는 두 가지를 필요로 한다: 첫째, 가능한 한 많은 데이터를 유지 할 수 있다는 것을 보장하는 거대한 규모. 둘째, 우리가 정말로 유일한 백색 소음을 버리고, 모든 좋은 데이터를 유지하고 있음을 보장하는 지능형 필터링.”

Data management for LHCb experiment

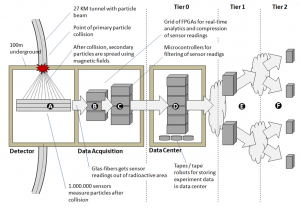

이러한 과제를 해결하기 위해 LHCb 팀은 이 실험들에 의해 생성된 데이터를 관리하는 여러 단계의 접근 방식을 설정하고 있다 (개요는 도표1 참조):

• [A] 1,000,000개의 센서는 주요 입자 충돌 (2) 시점 직후, 주요 LHCb 동굴 안에 있는 탐지기 내부에 배치된다. 일단 충돌이 일어나면, 모든 센서가 현재 고르게 분포 된 입자의 일부를 잡아낼 수 있도록, 이차 입자를 분산시키기 위한 자석이 사용된다. 실험의 특성상, 실험이 진행될 때 이 장소에는 막대한 방사능이 있게 된다. 센서 자체는 상이한 그룹으로 구성되어 있다. 예를 들어, 메인 추적기는 궤도를 재구성하고 하전 입자의 속도를 측정하도록 돕는 센서를 포함한다. 전자기 및 강입자 열량계는 전자, 광자 및 강입자의 에너지를 측정한다. 이러한 측정은 소위 “큰 횡방향 운동량”으로 입자를 식별하는 유인 수준에서 사용된다 ([C] 참조).

• [B] 높은 수준의 방사능으로부터 컴퓨터 장비를 보호하기 위해, 센서로부터의 아날로그 데이터는 유리 섬유 망을 거쳐 대규모 콘크리트 벽을 통해 전달된다. 데이터 전송 속도는 1 MHz이다. 아날로그 데이터를 가공하기 위한 이 시스템의 첫 단계는 수신 된 아날로그 데이터에 고성능의 실시간 데이터 압축 알고리즘을 실행하는 업무를 부여받은 FPGA 장치 (Field-Programmable Gate Arrays)의 그리드로 이루어진다.

• [C] 그 다음, 간결한 센서 판독은 사건의 예비 “복원”을 생성하도록 인접한 범용 서버 (> 1500 서버)의 큰 그리드에 의해 가공된다. 이러한 가공 단계는 다양한 센서로부터 데이터를 상호 연관시키기 위해 센서의 3D 위치에 대한 상세한 정보를 이용한다. 이 분석이 소위 “트리거”를 만들어내는 경우, 스냅 샷이 생성된다. 이러한 유형의 각 트리거 사건의 경우, 사건의 데이터는 (예: 그 시점의 모든 센서 데이터의 스냅 샷) 파일에 기록되어 LAN을 통해 외부 데이터 센터 (예: 지상)로 전송된다. 이 단계가 완료되었을 때, 데이터 전송 속도는 1 MHz에서 5 KHz로 떨어진다.

• [D] 메인 CERN 데이터 센터 (다른 실험들과 공유)는 시스템의 0단계에 해당되며, 영구 데이터 저장 장치를 위한 테이프 로봇 생산 지역뿐만 아니라 데이터를 가공하기 위한 컴퓨터 재고품의 그리드로 구성되어 있다. LHCb 데이터 센터의 입력 처리 능력은 초당 3MB이다. 스토리지 관리뿐만 아니라, 데이터 센터의 주요 작업은 사건의 “안전한” 오프라인 복원을 보장하는 것이며, 이는 다음 단계에서 보다 자세히 설명될 것이다. • [E] 데이터는 CERN 0단계로부터 다른 나라에 있는 12개의 1단계 장소로 배포된다. 이는 실험 데이터의 새로운 복사본 생성을 가능하게 하는 10 GB의 전용 네트워크 연결을 통해 전달된다. • [F] 약 200개의 2단계 장소는 추가 분석을 위해 선택된 데이터를 수신하고, 탐지기의 모의 실험 자료를 만든다 (탐지기 및 분석의 최적화 및 보정을 위해). 2단계 장소의 대부분은 대학 또는 다른 과학 기관이다.

CERN이 선택한 데이터 관리를 위한 여러 단계의 접근 방식은 매우 효율적이라고 입증되었다. CERN은 슈퍼 컴퓨터의 필요없이, 다양한 실험으로부터의 데이터를 가공하는 데 필요한 전체 용량의 15 %를 제공한다. 데이터 스토리지 서비스 (DSS) 그룹의 섹션 리더 Massimo Lamanna에 의하면, “각 충돌로부터의 데이터는 대략 1 ~ 10MB로 비교적 적다. 문제는 매년 수십 개 페타 바이트의 충돌을 필요로 하는 엄청난 수의 충돌이다. 각각의 충돌이 완전히 독립적이기 때문에, 우리는 CERN 컴퓨터 센터와 WLCG 그리드의 많은 접속점에 걸쳐 복원 절차를 분배 할 수 있다. 놀랍게도, 우리가 수행하는 계산은 2개의 콘센트, SATA 드라이브, 표준 이더넷 네트워크 및 리눅스 운영 체제와 표준 PC (x86)의 대규모 서버를 사용하여 매우 효과적으로 이루어질 수 있다. 이 접근 방식은 지금까지 우리 문제에의 가장 비용 효율적인 솔루션이라고 입증 되었다.”

가공 용량을 증가시키고 비지니스 연속성을 보장하기 위해, 최근 CERN는 헝가리 부다페스트에 두 번째 데이터 센터를 열었다. 이 데이터 센터는 제네바에 있는 메인 컴퓨터 센터의 확장자 역할을 수행하며, 원래의 데이터 센터와 같은 하드웨어 및 소프트웨어 아키텍처를 사용한다. 부다페스트 센터는 총 100,000개의 가공용 코어를 가져오는 45 페타바이트의 추가 디스크 저장 공간을 제공한다.

LHCb와 물리적 데이터 분석

LHCb 실험의 기초가 되는 물리학 이론에 너무 상세하게 접근하지 않고, 우리는 논리적 관점으로 데이터 분석을 간단히 살펴볼 것이다. 이후에 볼 수 있듯이, 비물리학자로서도 여기에서 많은 것을 배울 수 있다.

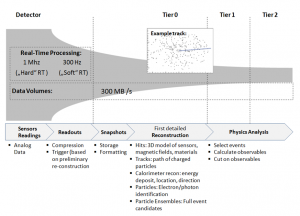

충돌은 감지 될 필요가 있는 다수의 이차 입자를 생성한다. 이러한 이차 입자는 주어진 궤도, 속도 등에 기초한 3차원 공간에서 이동한다. 가공되지 않은 아날로그 데이터는 입자가 통과하는 지점의 집합인 센서에 의해 전달된다. 표준 IT 시스템으로 가공하기에는 가공되지 않은 아날로그 데이터의 양이 너무 많기 때문에, FPGA와 마이크로 컨트롤러의 결합은 “트리거”를 생성하기 위해 함께 작동하며, 이는 제시간에 주어진 지점에 존재하는 모든 센서 데이터의 집합인 판독 값의 생성을 시작한다.

이러한 판독 값은 데이터 센터에 전송되며, 이 곳에서 판독 값은 감지기의 상태의 스냅 샷을 생성하기 위해 저장되고 기본 설정 작업을 겪게 된다.

0단계 데이터 센터에서 수행되는 처리기의 핵심 작업 중 하나는 복원 처리이다. 개개의 부딪힘은 (삼차원 공간에서 개별 센서에 의해 감지된) 상관관계에 있으며 궤도 (예: 감지기를 통하는 하전 입자의 경로)를 형성하기 위해 집단화된다. 하전 및 중성 입자의 에너지 침적은 열량계의 복원을 통해 감지되며, 이는 정확한 에너지 침적 수준, 위치 및 방향 결정을 돕는다. 결합된 복원은 예를 들어 상관된 전자 및 광자를 식별하기 위해, 다수의 입자 궤도를 살핀다. 최종 결과는 입자 앙상블의 완전한 복원이다.

그 다음 입자 앙상블은 1단계와 2단계 센터에서 물리학자에게 이용 가능하게 된다. 1단계 및 2단계에서 수행되는 물리학적 분석의 일반적인 목적은 수준은 입자 또는 새로운 현상을 확인하고, 기본 이론의 일관성 검사를 수행하는 것이다. 이 단계에서 일하는 과학자들은 종종 그들이 조사하고 있는 현상의 모의 실험과 함께 시작한다. 그 다음에 0단계-복원 단계의 산출은 더 정제되고 모의 실험의 예측과 비교된다. 결합될 경우, 모의 실험 및 0단계 실험 데이터는 종종 수십 페타바이트의 데이터를 포함한다.

Logical data analysis

LHCb’s Asset Integration Architecture

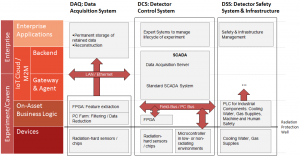

도표3은 LHCb 실험의 자산 통합 아키텍처 (AIA)의 개요를 제공한다 (AIA에 대한 자세한 설명은 [참조]를 보십시오). 사례 연구의 목적에 따라, 주 자산은 감지기이며, 우리는 입자 가속기 자체는 고려하지 않을 것이다. 검출기는 세 가지 주요 시스템에 의해 지원된다.

• 데이터 수집 시스템 (DAQ): DAQ는 감지기의 중심 부분이며 막대한 양의 아날로그 데이터를 디지털 관점에서 관리 가능한 수준으로 고속 처리하는 것을 담당한다. 이 장치는 대부분이 방사선 경화 센서와 칩이다. DAQ의 지역 자산 관리는 우리가 위에서 보았듯이, 센서 판독 값을 압축하고 여과하는 FPGA와 마이크로 컨트롤러의 결합으로 구성되어 있다.

• 감지기 제어 시스템 (DCS): DCS는 LHCb 실험을 관리한다. 이는 주로 업계 표준 부품을 기반으로 한다. 예를 들어 표준 SCADA 시스템은 DCS에 사용된다.

• 감지기 안전 시스템 및 인프라 (DSS): DSS는 냉각수, 가스 공급 등의 중요한 요소를 관리한다. DSS는 주로 산업 부품을 관리하기 위한 표준 PLCs를 사용한다.

DAQ를 제외한 LHCb는 통상 산업 기계 (단연 매우 크고 복잡한 것)처럼 구성된다. 모두 DCS 및 DSS는 업계 표준 부품을 사용한다. 그러나 DAQ가 LHCb를 현장에서의 “빅 데이터” 최고 실례 중 하나로 만드는 반면, 장치 층은 방사선 경화 부품만을 사용할 수 있다.

Asset integration architecture

얻은 교훈들 및 견해

이 사례 연구는 우리가 다른 영역의 많은 IoT 및 빅 데이터 프로젝트에 적용 할 수 있다고 생각하는 몇 가지 교훈을 제공한다.

• 빅 데이터 수집 및 가공을 위한 여러 단계 아키텍처의 사용: 전체 데이터 가공 사이클은 전문화된 데이터 필터링과 보충 기능을 수행하는 각 단계와 큰 깔때기처럼 함께 행동하는 다수의 고도로 전문화 단계에 기초한다. 단계1과 단계2가 물리학 분석의 상이한 유형에 중점을 두는 반면, 단계0은 기초 데이터 복원과 배포 작업을 수행한다. CERN은 단계1, 2 에 데이터 가공 자원의 85 %를 아웃소싱하는 데 성공했다. 그리고 심지어 감지기 자체와 0단계의 데이터 센터 사이에서 데이터는 고성능 압축에서 최초의 필터링, 매체 전환 및 복원을 통한 여러 단계까지 포함하는 다수의 층을 통과한다. 각 단계는 레이어 최적화 기능을 수행한다.

• 고성능 아날로그 데이터 가공을 위한 특수 하드웨어의 사용: LHCb는 실시간 아날로그 데이터의 가공 및 압축 디지털 데이터로의 변환을 위한 고성능의 FPGA (Field-Programmable Gate Arrays)의 그리드를 사용한다. 이 FPGA 그리드의 이점은 특수한 하드웨어 기술 언어 (HDL)를 기반으로 소프트웨어 수준에서 다시 프로그래밍 될 수 있다는 점이다. 많은 경우에, FPGA는 훨씬 더 유연하지만 조금 덜 정확한 실시간 마이크로 컨트롤러의 “두 번째 경계”에서 통과되기 전에, 실시간 아날로그 데이터 가공에서 “첫 번째 경계”로 사용된다. 또한 이 단계에서 발생하는 “경화”의 실시간 처리는 데이터의 상관 관계의 차원으로 시간 사용을 위한 필수 조건이며, 이는 우리가 다음 지점에서 다루어야 하는 것이다.

• 센서 데이터의 상관 관계: 다양한 센서들로부터 데이터를 상호 연계하는 것은 “큰 그림”을 이해하기 위한 중요한 전제 조건이다. CERN LHCb에서 이는 타이밍 정보와 결합된 모든 센서의 3차원 위치를 이용하여 수행된다. 개념적으로, 3차원 감지기를 통해 입자의 움직임을 추적하는 것은, 예를 들면 (물론 규모 및 속도 제외하고) 쇼핑 센터를 통해 고객의 움직임을 추적하는 것과 크게 다르지 않다.

• 레버리지 그리드 컴퓨팅: 데이터 구조 및 분석 패턴이 다른 여러 덩어리로 작업 처리의 분할을 허용하기 때문에, 비싼 고성능의 슈퍼컴퓨터 대신에 저렴한 표준 하드웨어의 그리드를 사용하는 것이 가능하다.

그리고 마지막으로, 또 다른 중요한 교훈은 가능한 한 데이터 소스에 가까운 고급 필터 로직을 가져오는 필요성에 관한 것이다. Niko Neufeld, LHCb 데이터 수집 전문가인 Niko Neufeld는 “목표는 센서에 가까운 전체 데이터 복원을 수행하기 위해 트리거 시스템을 사용 가능하도록 해야 한다. 이는 우리가 어떤 데이터를 가능한 한 데이터 소스에 가깝게 유지할 것인지 결정하는 방법을 대폭 개선하도록 도와주어야 하며, 따라서 DAQ에서 초기 데이터 필터링 단계의 결과로 중요 데이터를 찾지 못할 가능성을 최소화한다.”라고 성명한다.

저자는 이 사례 연구에 대해 조언을 아끼지 않은 Sverre Jarp, Andrzej Nowak, Massimo Lamanna, Niko Neufeld에게 감사의 말씀을 전한다. CERN에서 수행된 업적은 많은 노벨상과 연관되어 왔고, 특히 2013 노벨 물리학상 수상자 Higgs-Engelman의 업적을 입증하도록 도왔으며, 그리고 IoT 및 빅 데이터 영역에서의 최고 모범 사례의 확립에 견고한 기반을 제공한다.